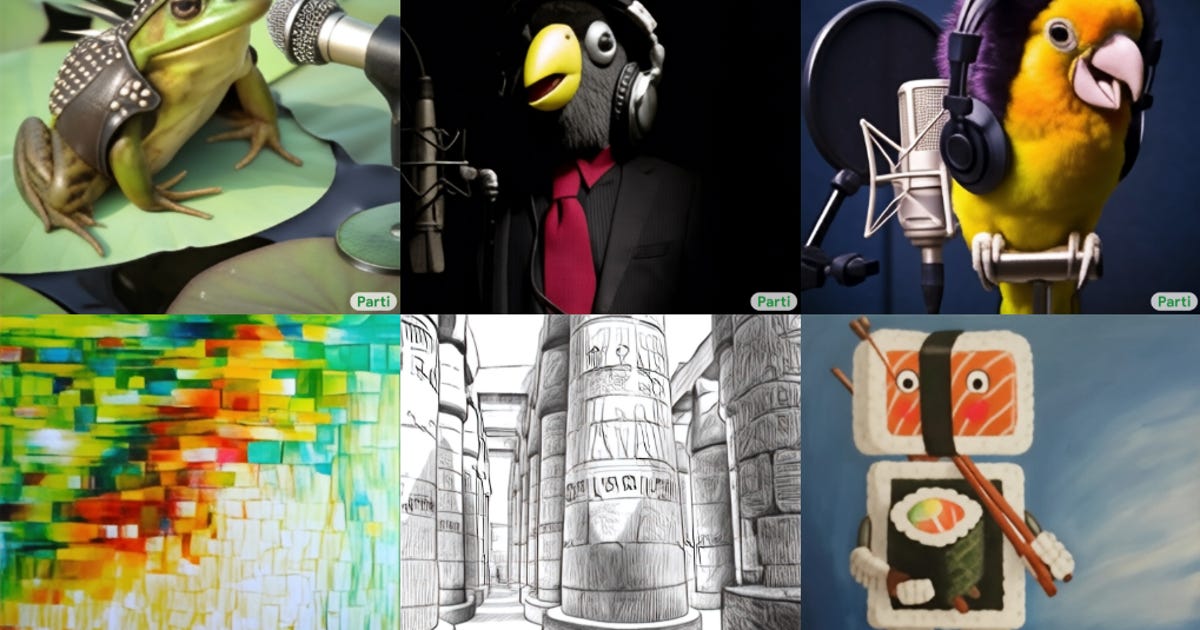

グーグルは木曜日に、数百億の入力を研究することによって超現実的な画像をレンダリングする、Partiのテキストから画像へのコンピュータモデルを発表しました。

Pathways Autoregressive Text-to-Image(Parti)は、Googleが「画像トークン」と呼んでいる一連の画像を調査し、それらを使用して新しい画像を作成すると、検索の巨人は次のように述べています。 研究ウェブサイト。 Partiの画像は、レビューするパラメーター(トークンやその他のトレーニング資料)が多いほど、よりリアルになります。 モデルは、最終的な画像を生成する前に200億のパラメーターを調査します。

Partiは、Googleが拡散学習を使用するように設計したテキストから画像へのジェネレータであるImagenとは異なります。 このプロセスでは、画像に「ノイズ」を追加してコンピュータモデルをトレーニングし、テレビ画面の静止画のように画像が不明瞭になるようにします。 次に、モデルはスタティックをデコードして元の画像を再作成することを学習します。 モデルが改善されると、一連のランダムなドットのように見えるものを画像に変えることができます。

AIデータセットにはバイアスのリスクがあるため、GoogleはPartiまたはImagenを一般に公開していません。 データセットは人間によって作成されているため、誤ってステレオタイプに傾いたり、特定のグループを誤って表現したりする可能性があります。 グーグルは、PartiとImagenの両方が 西洋のステレオタイプ。

Googleは会社に言及しました ブログ投稿 この話にコメントするように頼まれたとき。

検索の巨人は、サービスを改善し、アンビエントコンピューティングを開発する方法として、人工知能に多額の投資を行ってきました。これは、非常に直感的なテクノロジーの一種であり、背景の一部になります。 5月に開催されたI/O開発者会議で、CEOのSundar Pichaiは、Google翻訳が言語を追加し、マップで3D画像を作成し、ドキュメントを要約にまとめるのにAIが使用されていると述べました。

周りのテキストから画像へのモデルは、PartiとImagenだけではありません。 Dall-E、VQ-GAN + CLIP、および潜在拡散モデルは、最近注目を集めている他のGoogle以外のテキストから画像へのモデルです。 Dall-E Miniは、一般に公開されているオープンソースのテキストから画像へのAIですが、より小さなデータセットでトレーニングされています。